NVIDIA DGX ™ システムは、AI とデータサイエンスを導入する企業 の要求に応じた専用システムであり、インサイト獲得を数ヵ月後で はなく数時間で実現するために、AI 開発を最速で開始し、無理な く生産性を高め、画期的な性能をもたらします。

革新的な GPU 最適化ソフトウェアとシンプルな管理ツールを組み 合わせたこの完全統合型システムは、オフィスからデータセンター まで、AI 開発の最も強力なツールをデータサイエンティストに提供 するために設計されています。より早く実験し、最大規模のモデル をより高速でトレーニングし、データからインサイトを獲得しましょ う。第 1 日目から始められます。

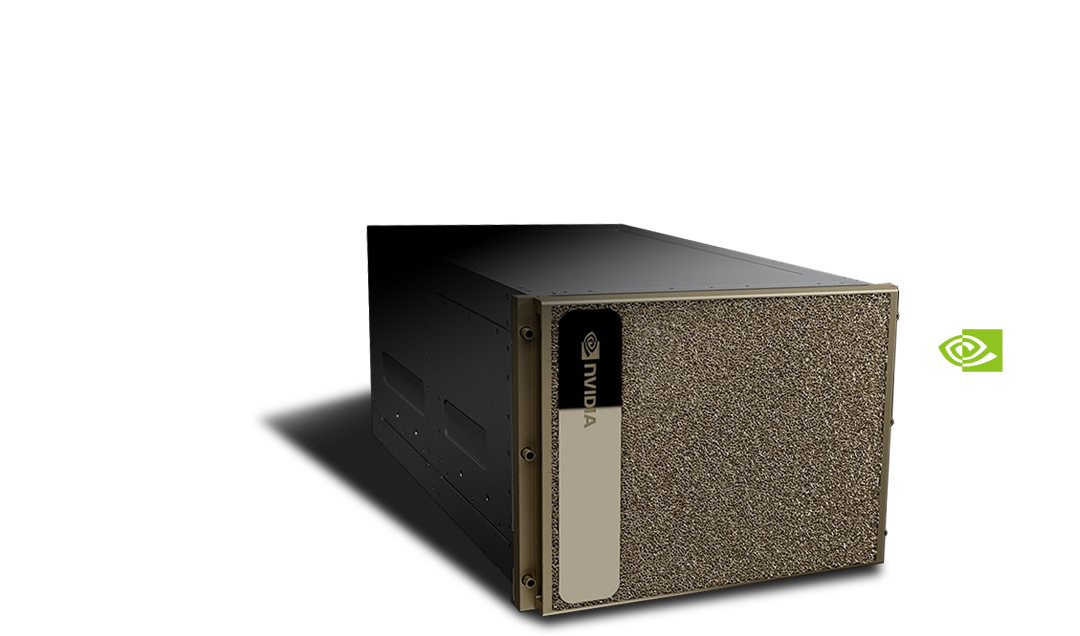

NVIDIA DGX H100

AI インフラストラクチャの金字塔。エンタープライズ AI 向けの、世界で認められた選択肢

NVIDIA DGX™ H100 でイノベーションと最適化の限界を広げましょう。NVIDIA の伝説というべき DGX Systems の最新バージョンであり、NVIDIA DGX SuperPOD™ の基盤となっている DGX H100 は、NVIDIA H100 Tensor コア GPU の画期的なパフォーマンスによって加速される、AI 対応の高性能製品です。

Characteristic特 徴

AI センター オブ エクセレンスの第一歩

DGX H100 は、世界初の専用 AI インフラストラクチャの第 4 世代であり、完全に最適化されたハードウェアおよびソフトウェア プラットフォームです。新しい NVIDIA AI ソフトウェア ソリューションに対応し、多様なサードパーティのサポートを受けられるエコシステムを利用でき、NVIDIA プロフェッショナル サービスによりエキスパートからのアドバイスを受けることができます。

AI の障壁を大胆に打ち破る

NVIDIA DGX H100 は 6 倍高速なパフォーマンス、2 倍高速なネットワーキング、およびハイスピードなスケーラビリティを NVIDIA DGX SuperPOD に対して発揮します。この次世代アーキテクチャは、自然言語処理やディープラーニングによるレコメンデーション モデルといった大規模なワークロードに対応できるように強化されています。

思いのままに使える、リーダーシップクラスのインフラストラクチャ

DGX H100 は、オンプレミスにインストールして直接管理したり、NVIDIA DGX 対応のデータ センターでの設置、NVIDIA 認定のマネージド サービス プロバイダーを通じてアクセスすることもできます。また、 DGX 対応のライフサイクル管理により、組織は予測性の高い財務モデルを入手して、最先端のデプロイメントを維持できます。

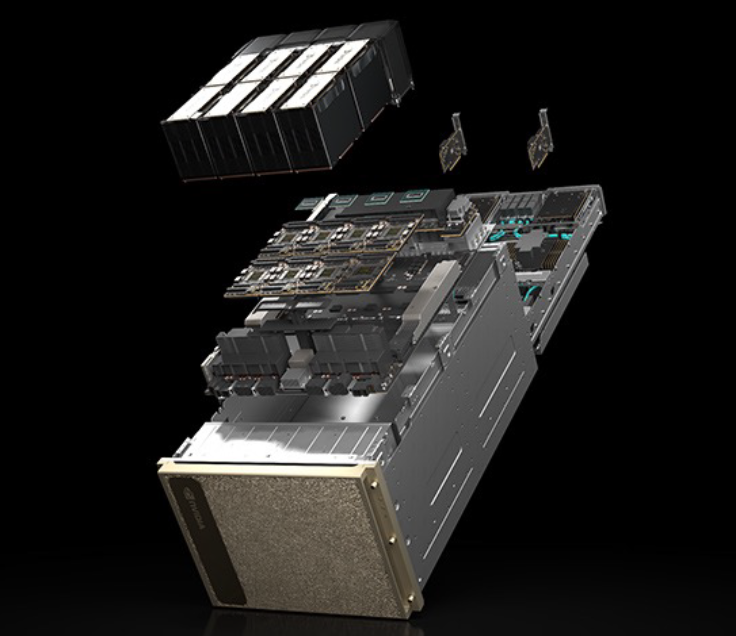

SummaryDGX H100 の高性能コンポーネントをご覧ください。

- NVIDIA H100 GPU x8、合計 GPU メモリ 640GB

GPU あたり 18 NVIDIA® NVLinks®、GPU 間の双方向帯域幅 900GB/秒 - NVIDIA NVSWITCHES™ x4

7.2 テラバイト/秒の GPU 間双方向帯域幅 、前世代比 1.5 倍以上 - NVIDIA CONNECTX®-7 x8 および、NVIDIA BLUEFIELD® DPU 400Gb/秒 ネットワーク インターフェイス x2

ピーク時の双方向ネットワーク帯域幅 1TB/秒 - デュアル x86 CPU と 2TB システム メモリ

AI への依存が非常に高い仕事を可能にするパワフルな CPU - 30TB NVMe SSD

最高のパフォーマンスを実現するための高速ストレージ