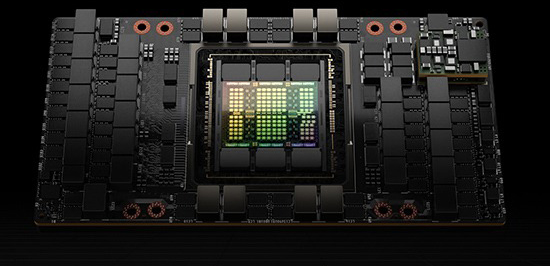

NVIDIA H100 Tensor コア GPU

あらゆるデータ センターにかつてない性能、拡張性、セキュリティを提供。

アクセラレーテッド コンピューティングの大きな飛躍

NVIDIA H100 Tensor コア GPU で、あらゆるワークロードのためのかつてない性能、拡張性、セキュリティを手に入れましょう。NVIDIA® NVLink® Switch System により、最大 256 個の H100 を接続し、エクサスケールのワークロードを高速化できます。さらに、専用の Transformer Engine を利用することで、パラメーターが兆単位の言語モデルを実装できます。H100 の複合的な技術革新により、大規模な言語モデルが前世代と比較して 30 倍も高速化され、業界の一歩先を行く対話型 AI が可能となります。

エンタープライズからエクサスケールまで

ワークロードを安定に高速化

最大規模のモデルでAI トレーニング性能を最大 9 倍に

混合エキスパート (3950 億個のパラメーター)

予想されるパフォーマンスは変更される可能性があります。Training Mixture of Experts (MoE) Transformer Switch-XXL バリアントと 1T トークン データセット上の 395B パラメーター | A100 クラスター: HDR IB ネットワーク | H100 クラスター: NVLINK スイッチ システム、NDR IB

革新的な AI トレーニング。

H100 は第 4 世代の Tensor コアと、FP8 精度で混合エキスパート (MoE) モデルのトレーニングを前世代比最大 9 倍高速化するTransformer Engine を備えます。GPU と GPU を毎秒 900 ギガバイトで相互接続する第 4 世代 NVLink、ノード全体で GPU ごとに通信を高速化する NVLINK Switch System、PCIe Gen5、NVIDIA Magnum IO™ ソフトウェアの組み合わせによって、小規模なエンタープライズから大規模な統合 GPU クラスターまで効率的なスケーラビリティが与えられます。

データ センター規模での H100 GPU 導入は卓越したパフォーマンスを実現し、あらゆる研究者に次世代のエクサスケール ハイパフォーマンス コンピューティング (HPC) と兆単位パラメーター AI をもたらします。

リアルタイムのディープラーニング推論。

AI は、さまざまなビジネスの課題を、同じくらいさまざまなニューラル ネットワークを使用して解決します。優れた AI 推論アクセラレータには、最高のパフォーマンスだけでなく、様々なネットワークを加速するための多様性も求められます。

H100 は、推論を最大 30 倍高速化し、遅延を最小限に抑えるなど、いくつか機能が強化され、市場をリードする NVIDIA の推論のリーダーシップをさらに拡大します。第 4 世代の Tensor コアは、FP64、TF32、FP32、FP16、INT8、そして今では FP8 まで、あらゆる精度を高速化し、大規模な言語モデルで精度を維持しながら、メモリ消費を削減して性能を向上します

最大規模のモデルで AI 推論性能を最大 30 倍に。

Megatron チャットボット推論 (5300 億個のパラメーター)

Projected performance subject to change. Inference on Megatron 530B parameter model chatbot for input sequence length=128, output sequence length=20 | A100 クラスター: HDR IB ネットワーク | H100 クラスター: 16 個の H100 構成のための NDR IB ネットワーク | 1 秒と 1.5 秒の場合の 32 A100 と 16 H100 の比較 | 2 秒の場合の 16 A100 と 8 H100 の比較

HPC アプリケーションのパフォーマンスが最大 7 倍に。

予想されるパフォーマンスは変更される可能性があります。3D FFT (4K^3) スループット | A100 クラスター: HDR IB ネットワーク | H100 クラスター: NVLink スイッチ システム、NDR IB | ゲノム シーケンシング (Smith-Waterman) | 1 A100 | 1 H100

エクサスケール ハイパフォーマンス コンピューティング。

NVIDIA データ センター プラットフォームは、ムーアの法則を超えるパフォーマンス向上を継続的に提供します。また、H100 の新しい画期的な AI 機能は、HPC+AI のパワーをさらに増幅し、世界の最重要課題の解決に取り組む科学者や研究者にとって、発見までの時間が加速されます。

H100 は、倍精度 Tensor コアの毎秒浮動小数点演算 (FLOPS) を 3 倍にし、HPC で 60 teraFLOPS の FP64 コンピューティングを実現します。AI と融合した HPC アプリケーションでは、H100 の TF32 精度を活用し、コードの変更なしに、単精度行列乗算演算で 1 petaFLOP のスループットを達成することができます。

H100 はまた、DPX 命令を備え、NVIDIA A100 Tensor コア GPU の 7 倍のパフォーマンスを提供し、DNA シーケンス アライメント用の Smith-Waterman など、動的プログラミング アルゴリズムにおいて従来のデュアルソケット CPU のみのサーバーと比較して 40 倍の高速化を実現します。