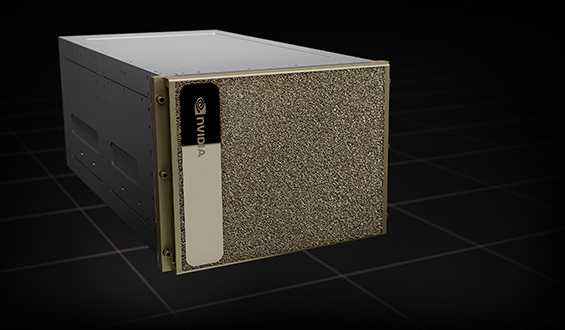

NVIDIA DGX H200

AI インフラストラクチャの金字塔。

エンタープライズ AI 向けの、世界で実証された選択

NVIDIA DGX™ H200 でビジネス イノベーションと最適化を広げましょう。DGX プラットフォームの一部であり、NVIDIA DGX SuperPOD™ や DGX BasePOD™ の基盤となっている DGX H200 は、NVIDIA H200 Tensor コア GPU の画期的なパフォーマンスにより高速化された、AI 対応の高性能製品です。

完全無欠な AI プラットフォーム

AI センター オブ エクセレンスの第一歩

AI センター オブ エクセレンス を DGX H200 で構築しましょう。DGX H200 は、NVIDIA Base Command™ や NVIDIA AI Enterprise ソフトウェア スイートが含まれた、完全統合型のハードウェア/ソフトウェア ソリューションです。また、NVIDIA DGXperts から専門家のアドバイスを受けることもできます。

AI スケーリングの障壁を打ち破る

DGX H200 アーキテクチャでは、32 petaFLOPS の AI パフォーマンス、前世代と比較して2 倍の速度になったネットワーク、高速のスケーラビリティを利用できます。このソリューションは、生成 AI、自然言語処理、ディープラーニングによるレコメンデーション モデルなどの大規模なワークロードに対応できるように強化されています。

リーダーシップクラスのインフラを思いのままに

DGX H200 のパワーを、オンプレミス、コロケーション、マネージド サービス プロバイダーからのレンタルなど、さまざまな方法で体験しましょう。また、DGX 対応のライフサイクル管理により、組織は予測性の高い財務モデルを入手して、最先端のデプロイを維持できます。

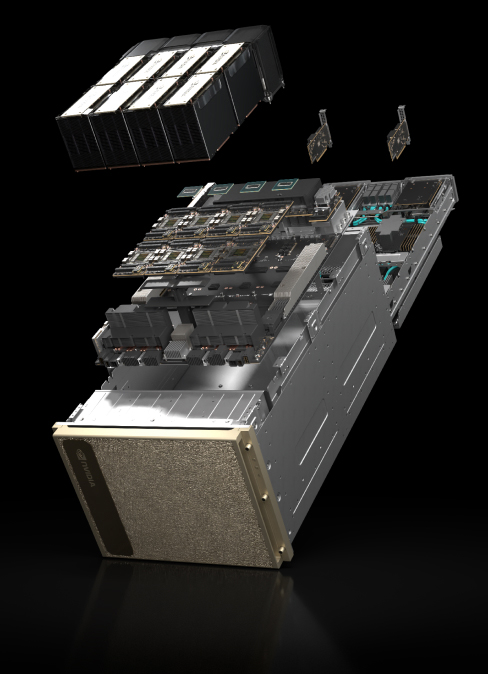

NVIDIA DGX H200 を見る

- 8x NVIDIA H200 GPU、合計 GPU メモリ 1,128GB

18x NVIDIA® NVLinks® 接続/GPU、GPU 間の双方向帯域幅 900GB/秒 - 4x NVIDIA NVSwitch™

GPU 間の双方向帯域幅 7.2TB/秒、前世代の 1.5 倍 - 10x NVIDIA ConnectX®-7、400Gb/秒のネットワーク インターフェイス

ピーク時の双方向ネットワーク帯域幅 1TB/秒 - デュアル Intel Xeon Platinum 8480C プロセッサ、合計 112 個のコア、2TB システム メモリ

AI への依存度が非常に高い仕事を可能にするパワフルな CPU - 30TB NVMe SSD

最高のパフォーマンスのための高速ストレージ

NVIDIA H200 Tensor コア GPU

AI と HPC のワークロードを強化する。

生成 AI と HPC のための GPU

NVIDIA H200 Tensor コア GPU は、市場を一変させるパフォーマンスとメモリ機能で生成 AI と HPC ワークロードを強化します。HBM3e を搭載した初の GPU である H200 の大容量かつ高速のメモリは、HPC ワークロードのための科学コンピューティングを推進しながら、生成 AI と大規模言語モデル (LLM) の高速化を促進します。

ハイライト

新たなレベルのパフォーマンスを体験

LLama2 70B 推論

1.9倍の高速化

GPT3-175B 推論

1.6倍の高速化

高性能コンピューティング

110倍の高速化

利点

大容量で高速なメモリによる高いパフォーマンス

NVIDIA Hopper アーキテクチャをベースとする NVIDIA H200 は、毎秒 4.8 テラバイト (TB/s) で 141 ギガバイト (GB) の HBM3e メモリを提供する初の GPU です。これは、NVIDIA H100 Tensor コア GPU の約 2 倍の容量で、メモリ帯域幅は 1.4 倍です。H200 の大容量かつ高速なメモリは、生成 AI と LLM を加速し、エネルギー効率を向上させ、総所有コストを低減し、HPC ワークロードのための科学コンピューティングを前進させます。

Llama2 13B: ISL 128, OSL 2K | Throughput | H100 SXM 1x GPU BS 64 | H200 SXM 1x GPU BS 128

GPT-3 175B: ISL 80, OSL 200 | x8 H100 SXM GPUs BS 64 | x8 H200 SXM GPUs BS 128

Llama2 70B: ISL 2K, OSL 128 | Throughput | H100 SXM 1x GPU BS 8 | H200 SXM 1x GPU BS 32.

高性能な LLM 推論でインサイトを引き出す

進化し続ける AI の世界では、企業はさまざまな推論のニーズに対応するために LLM を利用しています。AI 推論アクセラレータは、大規模なユーザー ベース向けにデプロイする場合、最小の TCO で最高のスループットを実現する必要があります。

H200 は、Llama2 のような LLM を扱う場合、H100 GPU と比較して推論速度を最大 2 倍向上します。

HPC MILC- dataset NERSC Apex Medium | HGX H200 4-GPU | dual Sapphire Rapids 8480

HPC Apps- CP2K: dataset H2O-32-RI-dRPA-96points | GROMACS: dataset STMV | ICON: dataset r2b5 | MILC: dataset NERSC Apex Medium | Chroma: dataset HMC Medium | Quantum Espresso: dataset AUSURF112 | 1x H100 | 1x H200.

ハイパフォーマンス コンピューティングをスーパーチャージ

メモリ帯域幅は、より高速なデータ転送を実現することで、ボトルネックとなる複雑な処理を削減するため、ハイパフォーマンス コンピューティング アプリケーションにとって極めて重要です。シミュレーション、科学研究、人工知能のようなメモリを大量に使用する HPC アプリケーションでは、 H200 の高いメモリ帯域幅が、データへのアクセスと操作を効率化し、CPU と比較して 110 倍の早さで結果を得ることができます。

Llama2 70B: ISL 2K, OSL 128 | Throughput | H100 1x GPU BS 8 | H200 1x GPU BS 32

エネルギーと TCO の削減

H200 の導入により、エネルギー効率と TCO が新たなレベルに到達します。この最先端のテクノロジは、すべて H100 Tensor コア GPU と同じ電力プロファイル内で、かつてないパフォーマンスを提供します。AI ファクトリーとスーパーコンピューティング システムは、高速なだけでなく、環境にも優しく、AI と科学のコミュニティを推進する経済的優位性を提供します。