■経歴

2001年大阪大学基礎工学研究科システム人間系専攻、東京大学生産技術研究所にてヒューマノイドロボットの動作獲得などの研究に従事。

大阪大学 サイバーメディアセンター 情報メディア教育研究部門 講師を経て、2013年より京都大学, 大学院情報学研究科准教授。

■先生が取り組まれている研究はどんな内容でしょうか?

ロボットの研究ともう一つは画像認識です。特に、今注目しているのは、人工知能によって人の目の動きを測り、人の動作を解析します。画像を機械で見ることによって、介護の上手さを測るという研究をしています。

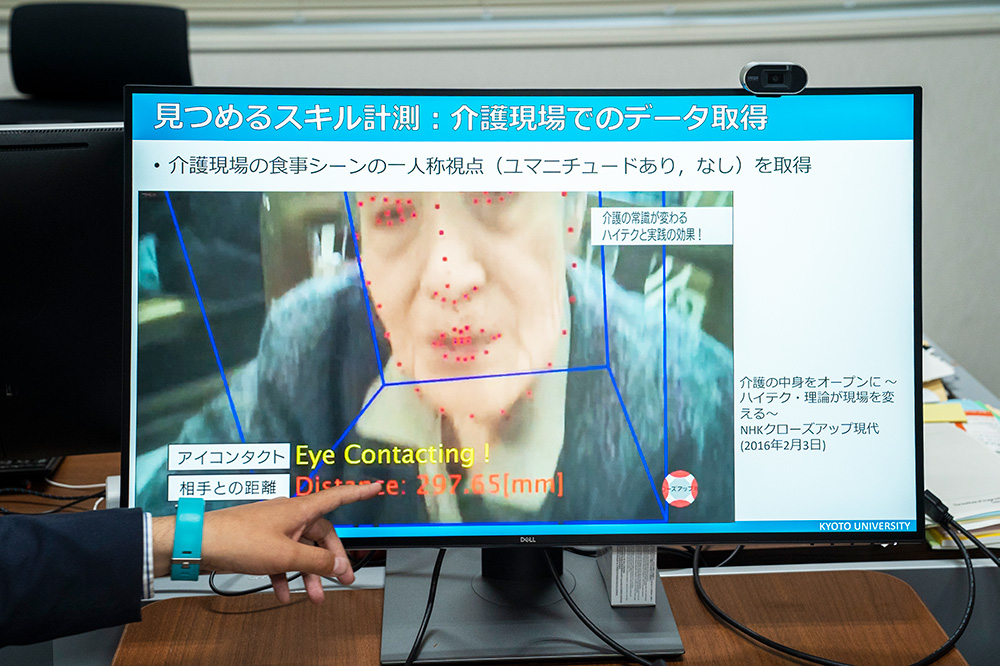

介護の上手な人、下手な人はどう行動が違うのかをウェアラブル・センシングや人工知能技術(AI)など使って、自動的に解析・認識することで、介護現場や家庭介護環境でのスキル向上を自己学習できるシステムの開発を目指しています。目線を測ると、上手な人は被介護者をよく見ていたり、目線が近かったり、話しかけや触れることがありますが、下手な人はなかったり。人と人とのコミュニケーションを画像認識で計測します。

■画像認識を具体的に教えていただけますか?

昔は3次元の奥行を測っていましたが、今は人の表情や触れる動作を測ることもできるようになってます。

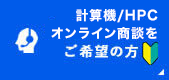

画像認識の技術を使えば、自分を映した写真で自分が誰といたか、どこにいたかまで分かってしまいます。例えば、自撮りをした自分の瞳に映っている背景をグーグルと照らし合わせて場所を特定したり、自分の目の前にいる人の顔までわかります。この技術は犯罪捜査でも使用されています。ネット上の自撮りはある程度、いろいろなことが分かってしまうので、とても危険ですよ(笑)

この研究に関しては、すでに論文で発表していますので、自分の手から離れ、企業やほかの人がさらに発展開発しているという感じです。

今、力を注いでいるのは認知症介護の分野です。医療者やベンチャー企業、ロボット研究者、心理学者たちとチームになり、「優しい介護ケア」として知られるユマニチュードのスキルを計測することを研究しています。人のコミュニケーション手法や触れるという動作はワンパターンではありません。視点映像で介護者と被介護者がどれくらい目線を合わせているのか、触れる時にはどこを見ているのか検出し、スキル向上に役立つようなシステムを開発しています。

実際、この教育システムは看護教育で使用されていて、看護学生が自分でウェアラブルセンサを付けて介護をし、自分がどれくらい上手なのかを知りましょうという学習も行われています。この研究により、介護者と被介護者のストレスを軽減したいと思っています。福岡市では、家族介護の人に教える市民講座も開催されています。

■弊社のワークステーションをどのように活用されていますか?

介護のデータ処理や画像認識などで、学生たちがディープラーニングの計算をするのに使用しています。動作生成やアイコンタクト、接触、画像認識などの計算をしています。

アプライドさんの製品は最新なので速い。計算量がたくさんできるのが役に立ってます。同時に動かすことが多いのでかなりパワーが必要なのですが、アプライドさんの製品のおかげで3割は早くなってます。2日かかっていたのが、1日半でできるようになりました。

ディープラーニングは機械に自動学習させています。読み込ませるデータが多ければ多いほど、出てくる結果の精度が上がるので、ディープラーニングで最終的に勝つのは計算能力だと思っています。

■これからの傾向は?

これからは研究において深層学習、ディープラーニングにするのが必要ですね。計算力では大手企業にはかなわないし、AIの世界になるのは目に見えているのですが、逆に人が動く必要がある介護に着目しています。介護のデータは人でしかとれないですし、介護問題は世界中で日本でしか問題になってないので、まずは日本でとれるデータをとって研究することに意味があると思います。